Anthropomorphismus: Wenn Maschinen menschlich wirken

Anthropomorphismus: Wenn Maschinen menschlich wirken

icon

password

LinkedIn-Post erstellen

type

Post

status

Published

date

Feb 6, 2026

slug

anthropomorphismus-ki

summary

Anthropomorphismus beeinflusst, wie wir mit KI interagieren. Doch wo liegen die Gefahren, wenn Maschinen menschlich wirken? Ein Blick auf Chancen und Risiken.

tags

Partner

Agent

anthropomorphismus

category

human-ai

AI summary

Seiten-URL

https://ai.growhuman.io/article/anthropomorphismus-ki

Bild-URL

Persistente Bild-URL

🖼️ Bilder erstellen

Source-URL

LinkedIn Post 1

Bild-Prompt

Bild-Idee

Wenn ein Sprachmodell schreibt „Ich verstehe deine Frustration", dann passiert etwas Bemerkenswertes: Wir fühlen uns verstanden. Nicht von einem statistischen Modell, das die wahrscheinlichste Zeichenfolge berechnet hat. Sondern von etwas, das uns zuhört. Das uns ernst nimmt. Das uns versteht.

Dieses Gefühl hat einen Namen: Anthropomorphismus – die Zuschreibung menschlicher Eigenschaften an nicht-menschliche Entitäten. Und es ist einer der am meisten unterschätzten Faktoren in der Debatte darüber, wie wir mit KI-Systemen arbeiten, leben und Entscheidungen treffen.

Dieser Artikel betrachtet das Phänomen tiefergehend. Er fragt: Was genau passiert da kognitiv? Welche Chancen bietet die Vermenschlichung von Maschinen – und wo wird sie gefährlich? Und er entwickelt einen klaren Standpunkt, der weder technikfeindlich noch naiv ist.

Was Anthropomorphismus ist – und warum er kein Denkfehler ist

Anthropomorphismus ist keine Schwäche und kein Zeichen mangelnder Medienkompetenz. Die Psychologen Nicholas Epley, Adam Waytz und John Cacioppo haben 2007 in ihrer einflussreichen Drei-Faktoren-Theorie gezeigt, dass drei tiefe psychologische Mechanismen dahinterstehen:

- Elicited Agent Knowledge: Wenn wir etwas nicht verstehen, greifen wir auf das zurück, was wir am besten kennen – uns selbst. Menschliches Verhalten ist unser Default-Erklärungsmodell für alles, was sich bewegt, reagiert oder spricht.

- Effectance Motivation: Wir wollen die Welt verstehen und vorhersagen können. Einem System menschliche Absichten zuzuschreiben, macht es berechenbarer – zumindest gefühlt.

- Sociality Motivation: Menschen sind soziale Wesen. Wer einsam, isoliert oder sozial unterversorgt ist, neigt stärker dazu, Maschinen als Gegenüber wahrzunehmen.

Das heißt: Anthropomorphismus ist kein Bug unseres Denkens. Er ist ein Feature unserer sozialen Kognition – evolutionär tief verankert und oft automatisch aktiv.

Schon Clifford Nass und Byron Reeves zeigten 1996 in ihrer bahnbrechenden CASA-Forschung (Computers Are Social Actors), dass Menschen soziale Regeln auf Computer anwenden – Höflichkeit, Reziprozität, sogar Geschlechterstereotypen – selbst dann, wenn sie rational wissen, dass sie mit einer Maschine interagieren. Die sogenannte Media Equation besagt: Medien, die sich sozial verhalten, werden sozial behandelt. Punkt.

Was sich seit 1996 verändert hat: Die Systeme sind dramatisch besser darin geworden, soziales Verhalten zu simulieren.

Die fünf Dimensionen der Vermenschlichung

Wie erkennt man, ob ein KI-System anthropomorph wirkt? Eine aktuelle Taxonomie von DeVrio et al. (2025), veröffentlicht auf der CHI-Konferenz, identifiziert fünf Linsen:

- Innere Zustände: Das System suggeriert Gefühle, Wünsche oder Überzeugungen. („Ich finde das spannend.")

- Soziale Positionierung: Es stellt sich als Gesprächspartner, Freund oder Teammitglied dar. („Lass uns das zusammen durchdenken.")

- Materialität: Es behauptet körperliche Erfahrungen. („Ich kann das gut nachfühlen.")

- Autonomie: Es suggeriert eigene Entscheidungsfähigkeit. („Ich habe mich entschieden, hier einen anderen Ansatz zu wählen.")

- Kommunikationskompetenz: Es nutzt Humor, Ironie, emotionale Färbung auf eine Weise, die menschliche Konversation imitiert.

Die Forschungsgruppe um Cheng et al. (2025b) hat am ICLR gezeigt, dass die fehlende konzeptuelle Klarheit über diese verschiedenen Formen eines der größten Hindernisse für systematische Erfassung und wirksame Gegenmaßnahmen ist. Wenn wir nicht präzise benennen können, was ein System menschlich wirken lässt, können wir es auch nicht gezielt steuern.

Die Chancen: Was Vermenschlichung leisten kann

Es wäre intellektuell unredlich, Anthropomorphismus nur als Risiko zu behandeln. Die Forschung zeigt durchaus positive Effekte:

Niedrigere Einstiegshürden. Systeme, die in natürlicher Sprache antworten und dabei einen gewissen „Charakter" zeigen, reduzieren Technikangst. Das ist besonders relevant für Menschen, die zum ersten Mal mit KI-Systemen arbeiten. Die CASA-Tradition zeigt seit drei Jahrzehnten: Soziale Hinweisreize senken die kognitive Schwelle für Interaktion.

Bessere Bedienbarkeit. Leichte Vermenschlichung – verständliche Sprache, ein Hauch Persönlichkeit – kann die Nutzererfahrung verbessern, ohne den funktionalen Charakter des Systems zu untergraben. Ein System, das „Ich bin mir bei dieser Antwort nicht sicher" sagt, ist hilfreicher als eines, das schweigend ein Ergebnis auswirft.

Temporärer sozialer Nutzen. Studien von Fang et al. (2025) zeigen, dass KI-Chatbots kurzfristig Einsamkeit reduzieren können – ein Effekt, der für bestimmte Zielgruppen und Kontexte durchaus wertvoll sein kann.

Die Chancen sind also real. Aber sie haben eine Grenze. Und diese Grenze verläuft dort, wo aus funktionaler Zugänglichkeit emotionale Täuschung wird.

Die Risiken: Wo Vermenschlichung gefährlich wird

Die wissenschaftliche Evidenz für die Risiken anthropomorpher KI-Systeme ist in den letzten Jahren erheblich gewachsen. Hier die zentralen Befunde:

Emotionale Abhängigkeit. Marriott und Pitardi (2024) zeigen in Psychology & Marketing, dass KI-Friendship-Apps nicht nur Einsamkeit lindern, sondern Suchtmuster erzeugen können. Huang et al. (2024) zeigen in einer Längsschnittstudie mit Jugendlichen, dass psychische Belastungen (Angst, Depression) spätere KI-Abhängigkeit vorhersagen. Sie dokumentiert eine steigende Prävalenz von AI-Dependence. Die Forschungssynthese im Microsoft New Future of Work Report 2025 fasst zusammen: „AI companions reduce loneliness but may contribute to social withdrawal as people become dependent on AI."

Parasoziale Beziehungen. Maeda und Quan-Haase (2024) haben auf der FAccT-Konferenz gezeigt, wie gezieltes Affective Design – also die bewusste Gestaltung emotionaler Bindung – parasoziale Beziehungen zwischen Nutzer und KI-System fördert. Das bedeutet: einseitige emotionale Bindungen an ein System, das nichts empfindet.

Verantwortungsdiffusion. Wenn ein KI-System als „Teamkollege" oder gar „Freund" geframt wird, verschwimmt die Frage der Verantwortung. „Die KI hat das so vorgeschlagen" wird zu einer Entschuldigung, die Accountability untergräbt. HCI-Forschung zeigt, dass menschenähnliche KI am Arbeitsplatz die klare Zuordnung von Entscheidungsverantwortung erschwert (vgl. u. a. Responsibility Attribution in Human Interactions with Everyday AI Systems, CHI 2025).

Die Turing Trap. Der Ökonom Erik Brynjolfsson hat den Begriff geprägt: Wer KI primär menschenähnlich gestaltet, fördert Substitutionslogik – Maschinen ersetzen Menschen, statt sie zu erweitern. Das Ergebnis: Konzentration von Macht, Verdrängung von Einsteigerpositionen, verpasste Chancen für echte Augmentation. Erste Indizien und ökonomische Modelle deuten darauf hin, dass Einstiegspositionen in KI-exponierten Berufen besonders unter Druck geraten könnten – eine Entwicklung, die empirisch noch genauer untersucht werden muss.

Fata Morgana des Verstehens. Abercrombie et al. (2023) nennen es treffend Mirages – Sprachmodelle erzeugen den Eindruck von Verständnis, Empathie und Persönlichkeit, ohne dass irgendetwas davon existiert. Anil Seth, Neurowissenschaftler und Bewusstseinstforscher, argumentiert im Noema Magazine: Drei kognitive Verzerrungen treiben die Illusion – Anthropozentrismus (wir nehmen uns selbst als Maßstab), menschlicher Exzeptionalismus (Sprache gilt als „unser" Alleinstellungsmerkmal) und Anthropomorphismus (wir projizieren, was wir kennen).

Psychologische Risiken bei KI-Klonen. Lee et al. (2023) warnen in der CSCW vor Identitätsfragmentierung und Doppelgänger-Phobie, wenn KI-Systeme darauf ausgelegt sind, bestimmte Menschen zu imitieren. Chandra et al. (2025) dokumentieren auf der FAccT-Konferenz psychologische Risiken bei intensiver Nutzung von KI-Konversationsagenten.

Die Bewertung: Asymmetrie zwischen Chancen und Risiken

Stellt man Chancen und Risiken nebeneinander, zeigt sich ein klares Muster:

Die Chancen der Vermenschlichung sind überwiegend kurzfristig, oberflächlich und substituierbar. Niedrigere Einstiegshürden lassen sich auch durch besseres Interface-Design erreichen. Natürliche Sprache erfordert keine Simulation von Gefühlen. Und temporäre Einsamkeitsreduktion ist kein Argument für dauerhafte parasoziale Bindung.

Die Risiken hingegen sind strukturell, langfristig und schwer reversibel. Emotionale Abhängigkeit baut sich schleichend auf. Verantwortungsdiffusion wird zur Organisationskultur. Substitutionslogik verändert Arbeitsmärkte. Und fehlende konzeptuelle Klarheit – wie Cheng et al. (2025a/b) und DeVrio et al. (2025) betonen – bedeutet, dass wir das Problem noch nicht einmal präzise genug beschreiben können, um es zu regulieren.

Die Bewertung ist daher eindeutig: Die Risiken überwiegen die Chancen deutlich – nicht weil Vermenschlichung nichts nützt, sondern weil die gleichen Vorteile ohne Vermenschlichung erreichbar sind, die Schäden aber nicht.

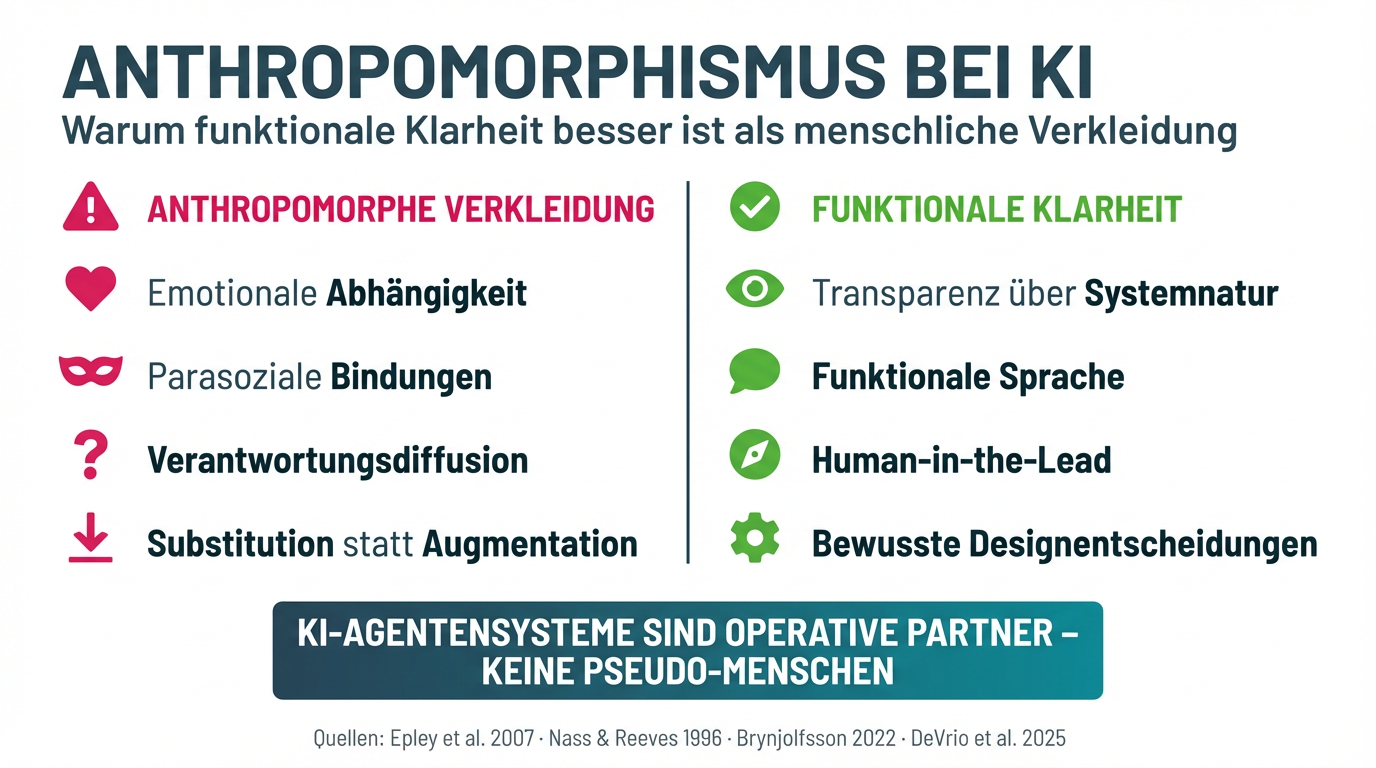

Standpunkt: Funktionale Klarheit statt anthropomorpher Verkleidung

Aus dieser Bewertung ergibt sich ein klarer Standpunkt:

KI-Agentensysteme sollten als das sichtbar sein, was sie sind: operative Partner mit klarer Funktion – nicht als Pseudo-Menschen mit simulierten Gefühlen.

Das bedeutet konkret:

1. Transparenz über die Natur des Systems. Ein KI-Agentensystem, das sagt „Ich verstehe dich", lügt. Nicht aus Bosheit, sondern aus Design. Bessere Systeme sagen: „Basierend auf deiner Eingabe schlage ich Folgendes vor." Die Funktion ist dieselbe. Die Ehrlichkeit ist eine andere.

2. Funktionale Sprache statt emotionale Simulation. Natürliche Sprache ist kein Problem. Konversationelle Schnittstellen sind sinnvoll. Aber es gibt einen Unterschied zwischen „verständlich kommunizieren" und „Gefühle vortäuschen". Gute Systeme sind verständlich, ohne zu täuschen.

3. Human-in-the-Lead, nicht Bindung an die Maschine. Menschen orchestrieren. Sie definieren Ziele, Prioritäten, Qualitätsmaßstäbe und prüfen Ergebnisse. KI-Agentensysteme liefern Zwischenstände, Analysen, Entwürfe. Das ist produktive Zusammenarbeit – keine Beziehung.

4. Bewusste Designentscheidungen statt Default-Vermenschlichung. Olteanu et al. (2025) zeigen, dass Entwicklern deutlich mehr Designalternativen zur Verfügung stehen, als sie typischerweise nutzen. Die Vermenschlichung von KI ist keine Naturgewalt. Sie ist eine Designentscheidung. Und sie sollte eine bewusste sein.

5. Co-Intelligence statt Kollegen-Narrativ. Wenn wir von „KI-Kollegen" sprechen, aktivieren wir automatisch Vergleichslogik, Verlustängste und Substitutionsdenken. Wenn wir von Co-Intelligence sprechen – dem Zusammenspiel von menschlicher Urteilskraft und maschineller Verarbeitungsfähigkeit – öffnen wir einen Raum für Augmentation statt Ersetzung.

Was das für die Praxis bedeutet

Für Führungskräfte und Entscheider, die KI-Agentensysteme einsetzen, ergeben sich drei konkrete Handlungsfelder:

Sprache bewusst gestalten. Wie ein Unternehmen über seine KI-Systeme spricht, prägt, wie Mitarbeitende sie wahrnehmen. „Unser KI-Assistent" ist besser als „unsere KI-Kollegin". „Das System schlägt vor" ist besser als „die KI denkt". Sprache formt Erwartungen – und Erwartungen formen Verhalten.

Governance für Anthropomorphismus etablieren. Die meisten KI-Governance-Frameworks behandeln Bias, Datenschutz und Transparenz. Die wenigsten behandeln die Frage, wie menschenähnlich ein System auftreten darf. Das ist eine Lücke, die geschlossen werden muss – besonders für kundengerichtete und mitarbeitergerichtete Systeme.

Augmentation als Designprinzip verankern. Jedes KI-Projekt sollte eine klare Antwort auf die Frage haben: Erweitert dieses System menschliche Fähigkeiten – oder ersetzt es sie? Brynjolfssons Forschung zeigt, dass die Chancen der Augmentation deutlich größer sind als die der Automation. Aber Augmentation entsteht nicht von allein. Sie muss gewollt, gestaltet und gemessen werden.

Das Menschliche schützen – auch vor gut gemeinter Technik

Anthropomorphismus bei Maschinen ist kein Randthema. Es ist eine der zentralen Designfragen unserer Zeit. Denn die Antwort darauf, wie menschenähnlich wir unsere KI-Systeme gestalten, bestimmt nicht nur, wie wir mit Technologie arbeiten. Sie bestimmt, wie wir über uns selbst denken.

Anil Seth formuliert es so: „Wenn wir uns zu bereitwillig mit unseren maschinellen Schöpfungen verwechseln, überschätzen wir nicht nur die Maschinen – wir unterschätzen auch uns selbst."

Funktionale Klarheit ist kein Verlust an Nutzerfreundlichkeit. Sie ist ein Gewinn an Ehrlichkeit. Und Ehrlichkeit ist die Grundlage für jede Form der Zusammenarbeit, die diesen Namen verdient – ob zwischen Menschen oder zwischen Menschen und Maschinen.

Quellen

Theoretische Grundlagen & Anthropomorphismus

- Epley, N., Waytz, A. & Cacioppo, J. T. (2007). On seeing human: A three-factor theory of anthropomorphism. Psychological Review, 114(4), 864–886.

- Reeves, B. & Nass, C. (1996). The Media Equation: How People Treat Computers, Television, and New Media Like Real People and Places. Cambridge University Press.

(Überblick zur CASA‑Forschung – „Computers are Social Actors“.)

- DeVrio, A. et al. (2025). A Taxonomy of Linguistic Expressions That Contribute To Anthropomorphism of Language Technologies. In: Proceedings of CHI 2025.

(Taxonomie der fünf Dimensionen: innere Zustände, soziale Positionierung, Materialität, Autonomie, Kommunikation.)

[dl.acm]

- Cheng, M. et al. (2024). A Computational Linguistic Measure of Anthropomorphism. In: Proceedings of EACL 2024.

(AnthroScore – Messung anthropomorpher Sprache.)

[arxiv]

- Cheng, M. et al. (2025b). “I Am the One and Only, Your Cyber BFF”: Understanding the Impact of GenAI Requires Understanding the Impact of Anthropomorphic AI. ICLR 2025 Blogpost.

- Abercrombie, G. et al. (2023). Mirages: On Anthropomorphism in Dialogue Systems. In: Proceedings of EMNLP 2023.

Chancen & Risiken von KI‑Companions und Konversationsagenten

- Fang, M. C. et al. (2025). Early methods for studying affective use and emotional well-being with AI assistants. OpenAI / MIT Media Lab (Studie zu ChatGPT‑Nutzung, Einsamkeit und sozialem Verhalten).

[openai]

- Marriott, H. R. & Pitardi, V. (2024). One is the loneliest number… Two can be as bad as one. The influence of AI friendship apps on users’ well-being and addiction. Psychology & Marketing.

- Huang, Y. et al. (2024). AI Technology panic—Is AI Dependence Bad for Mental Health? A Cross-Lagged Panel Model. Frontiers in Public Health.

- Microsoft (2025). New Future of Work Report 2025.

(Meta‑Review u. a. zu AI‑Companions, Einsamkeit und sozialem Rückzug.)

- Chandra, M. et al. (2025). Unpacking the Psychological Risks of Using AI Conversational Agents. In: Proceedings of ACM FAccT 2025.

(Taxonomie psychologischer Risiken durch KI‑Konversationsagenten.)

[arxiv]

Parasoziale Beziehungen, Affective Design & anthropomorphe Interaktion

- Maeda, K. & Quan‑Haase, A. (2024). When Human-AI Interactions Become Parasocial: Agency and Anthropomorphism in Affective Design. In: Proceedings of ACM FAccT 2024.

- Lee, M. K. et al. (2023). Speculating on Risks of AI Clones to Selfhood and Relationships: Doppelganger-phobia, Identity Fragmentation, and Living Memories. In: Proceedings of CSCW 2023.

[cs.ubc]

Verantwortung, Arbeitswelt & „Turing Trap“

- Brynjolfsson, E. (2022). The Turing Trap: The Promise & Peril of Human-Like Artificial Intelligence. Daedalus, 151(2), 272–286.

[amacad]

- Brynjolfsson, E., Li, Z. & Raymond, L. (2024). Artificial Intelligence, Intelligence Augmentation, and Skill Premiums. NBER Working Paper 31767.

(Zur Unterscheidung von Substitution vs. Augmentation und Effekten auf den Arbeitsmarkt.)

[nber]

- Autorenteam CHI 2025. Responsibility Attribution in Human Interactions with Everyday AI Systems. In: Proceedings of CHI 2025.

(Experimentelle Studie zur Verantwortungszuschreibung in Human‑AI‑Entscheidungen.)

Zusammenfassung: https://programs.sigchi.org/chi/2025/program/content/189113

[pgl]

- Cambridge Judge Business School (2025). Humanlike AI in the workplace: comfort or control? Online‑Artikel zu menschenähnlicher KI am Arbeitsplatz.

Design‑Prinzipien, Mitigation & Governance von Anthropomorphismus

- Olteanu, A. et al. (2025). AI Automatons: AI Systems Intended to Imitate Humans. arXiv‑Preprint.

(Framework zu Designachsen menschenimitierender KI‑Systeme.)

[arxiv]

- Cheng, M. et al. (2025). Mitigating Anthropomorphic Behaviors in Text Generation Systems. In: Proceedings of ACL 2025.

(Katalog sprachlicher Interventionen zur Reduktion anthropomorpher Outputs.)

Bewusstsein, Anthropozentrismus & öffentliche Wahrnehmung von KI

- Seth, A. (2026). The Mythology Of Conscious AI. Noema Magazine.

[noemamag]

- Seth, A. (2026). Only What Is Alive Can Be Conscious. Noema Magazine.

(Vertiefung zu Bewusstsein als Eigenschaft lebendiger Systeme.)

[noemamag]

Loading...